Gosync.Pool 及其背後的機制

这是帖子的摘录;完整的帖子可以在这里找到:https://victoriametrics.com/blog/go-sync-pool/

这篇文章是关于 Go 中处理并发的系列文章的一部分:

- Gosync.Mutex:正常和饥饿模式

- Gosync.WaitGroup 和对齐问题

- Gosync.Pool 及其背后的机制(我们在这里)

- Gosync.Cond,最被忽视的同步机制

在VictoriaMetrics源代码中,我们经常使用sync.Pool,老实说它非常适合我们处理临时对象的方式,特别是字节缓冲区或切片。

标准库中常用。例如,在encoding/json包中:

package json

var encodeStatePool sync.Pool

// An encodeState encodes JSON into a bytes.Buffer.

type encodeState struct {

bytes.Buffer // accumulated output

ptrLevel uint

ptrSeen map[any]struct{}

}

在本例中,sync.Pool 用于重用 *encodeState 对象,该对象处理将 JSON 编码为 bytes.Buffer 的过程。

我们不会在每次使用后抛出这些对象,这只会给垃圾收集器带来更多工作,而是将它们存储在池中(sync.Pool)。下次当我们需要类似的东西时,我们只需从池中获取它,而不是从头开始制作一个新的。

您还会在net/http包中找到多个sync.Pool实例,它们用于优化I/O操作:

package http

var (

bufioReaderPool sync.Pool

bufioWriter2kPool sync.Pool

bufioWriter4kPool sync.Pool

)

当服务器读取请求主体或写入响应时,它可以快速从这些池中提取预先分配的读取器或写入器,从而跳过额外的分配。此外,还设置了*bufioWriter2kPool和*bufioWriter4kPool这2个写入池来处理不同的写入需求。

func bufioWriterPool(size int) *sync.Pool {

switch size {

case 2

好了,介绍就这么多了。

今天,我们将深入探讨sync.Pool的全部内容、定义、它的使用方式、幕后情况以及您可能想知道的所有其他内容。

顺便说一句,如果你想要更实用的东西,我们的 Go 专家有一篇很好的文章,展示了我们如何在 VictoriaMetrics 中使用sync.Pool:时间序列数据库中的性能优化技术:sync.Pool 用于 CPU 绑定操作

什么是sync.Pool?

简单来说,Go 中的sync.Pool 是一个可以保存临时对象以供以后重用的地方。

但是事情是这样的,你无法控制池中保留多少对象,并且你放入其中的任何东西都可以随时删除,没有任何警告,阅读上一节时你就会知道为什么。

好处是,池被构建为线程安全的,因此多个 goroutine 可以同时利用它。考虑到它是同步包的一部分,这并不奇怪。

“但是我们为什么要费心重用对象呢?”

当你同时运行很多 goroutine 时,它们通常需要类似的对象。想象一下同时运行 go f() 多次。

如果每个 goroutine 创建自己的对象,内存使用量会快速增加,这会给垃圾收集器带来压力,因为一旦不再需要这些对象,它就必须清理它们。

这种情况会造成一个循环,高并发导致高内存使用率,从而减慢垃圾收集器的速度。 sync.Pool 旨在帮助打破这个循环。

type Object struct {

Data []byte

}

var pool sync.Pool = sync.Pool{

New: func() any {

return &Object{

Data: make([]byte, 0, 1024),

}

},

}

要创建一个池,您可以提供一个 New() 函数,该函数在池为空时返回一个新对象。这个函数是可选的,如果你不提供它,如果池为空,则返回 nil。

在上面的代码片段中,目标是重用 Object 结构实例,特别是其中的切片。

重复使用切片有助于减少不必要的生长。

例如,如果切片在使用过程中增长到 8192 字节,您可以将其长度重置为零,然后再将其放回池中。底层数组的容量仍然是 8192,因此下次需要时,这 8192 字节就可以重用了。

func (o *Object) Reset() {

o.Data = o.Data[:0]

}

func main() {

testObject := pool.Get().(*Object)

// do something with testObject

testObject.Reset()

pool.Put(testObject)

}

流程非常清晰:您从池中获取一个对象,使用它,重置它,然后将其放回池中。重置对象可以在将其放回之前或从池中获取它之后立即完成,但这不是强制性的,这是常见的做法。

如果您不喜欢使用类型断言 pool.Get().(*Object),有几种方法可以避免它:

- 使用专用函数从池中获取对象:

func getObjectFromPool() *Object {

obj := pool.Get().(*Object)

return obj

}

- 创建您自己的sync.Pool通用版本:

type Pool[T any] struct {

sync.Pool

}

func (p *Pool[T]) Get() T {

return p.Pool.Get().(T)

}

func (p *Pool[T]) Put(x T) {

p.Pool.Put(x)

}

func NewPool[T any](newF func() T) *Pool[T] {

return &Pool[T]{

Pool: sync.Pool{

New: func() interface{} {

return newF()

},

},

}

}

通用包装器为您提供了一种更类型安全的方式来使用池,避免类型断言。

请注意,由于额外的间接层,它增加了一点点开销。在大多数情况下,这种开销很小,但如果您处于对 CPU 高度敏感的环境中,最好运行基准测试来看看是否值得。

但是等等,还有更多。

同步池和分配陷阱

如果您从之前的许多示例(包括标准库中的示例)中注意到,我们在池中存储的通常不是对象本身,而是指向该对象的指针。

让我用一个例子来解释为什么:

var pool = sync.Pool{

New: func() any {

return []byte{}

},

}

func main() {

bytes := pool.Get().([]byte)

// do something with bytes

_ = bytes

pool.Put(bytes)

}

我们正在使用[]字节池。通常(尽管并非总是),当您将值传递给接口时,可能会导致该值被放置在堆上。这种情况也发生在这里,不仅适用于切片,还适用于传递给 pool.Put() 的任何不是指针的内容。

如果使用逃逸分析进行检查:

// escape analysis $ go build -gcflags=-m bytes escapes to heap

现在,我不是说我们的变量字节移动到堆,我会说“字节的值通过接口转义到堆”。

为了真正理解为什么会发生这种情况,我们需要深入研究逃逸分析的工作原理(我们可能会在另一篇文章中这样做)。但是,如果我们将指针传递给 pool.Put(),则没有额外的分配:

var pool = sync.Pool{

New: func() any {

return new([]byte)

},

}

func main() {

bytes := pool.Get().(*[]byte)

// do something with bytes

_ = bytes

pool.Put(bytes)

}

再次运行逃逸分析,你会发现它不再逃逸到堆中。如果你想了解更多,Go源码中有一个例子。

同步池内部结构

在我们了解sync.Pool的实际工作原理之前,有必要先了解一下Go的PMG调度模型的基础知识,这确实是sync.Pool如此高效的支柱。

有一篇很好的文章用一些视觉效果分解了 PMG 模型:Go 中的 PMG 模型

如果您今天感到懒惰并正在寻找简化的摘要,我会支持您:

PMG 代表 P(逻辑 p处理器)、M(m机器线程)和 G(g或例程)。关键是每个逻辑处理器(P)在任何时候只能有一个机器线程(M)在其上运行。为了让 goroutine (G) 运行,它需要附加到线程 (M)。

这可以归结为两个关键点:

- 如果你有 n 个逻辑处理器 (P),只要你至少有 n 个机器线程 (M) 可用,你就可以并行运行最多 n 个 goroutine。

- 在任一时刻,单个处理器(P)上只能运行一个 goroutine(G)。因此,当 P1 忙于 G 时,没有其他 G 可以在该 P1 上运行,直到当前 G 被阻塞、完成或发生其他事情将其释放。

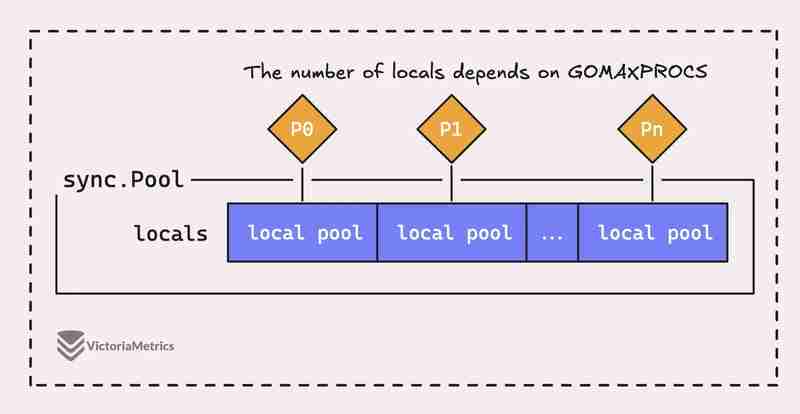

但问题是,Go 中的sync.Pool 不仅仅是一个大池,它实际上由几个“本地”池组成,每个池都与一个特定的处理器上下文(或 P)相关联,Go 的运行时是在任何给定时间进行管理。

当运行在处理器(P)上的 goroutine 需要池中的对象时,它会首先检查自己的 P 本地池,然后再查找其他地方。

完整的帖子可以在这里找到:https://victoriametrics.com/blog/go-sync-pool/

-

為什麼在我的Linux服務器上安裝Archive_Zip後,我找不到“ class \” class \'ziparchive \'錯誤?Class 'ZipArchive' Not Found Error While Installing Archive_Zip on Linux ServerSymptom:When attempting to run a script that utilizes the ZipAr...程式設計 發佈於2025-05-06

為什麼在我的Linux服務器上安裝Archive_Zip後,我找不到“ class \” class \'ziparchive \'錯誤?Class 'ZipArchive' Not Found Error While Installing Archive_Zip on Linux ServerSymptom:When attempting to run a script that utilizes the ZipAr...程式設計 發佈於2025-05-06 -

如何處理PHP文件系統功能中的UTF-8文件名?在PHP的Filesystem functions中處理UTF-8 FileNames 在使用PHP的MKDIR函數中含有UTF-8字符的文件很多flusf-8字符時,您可能會在Windows Explorer中遇到comploreer grounder grounder grounder gro...程式設計 發佈於2025-05-06

如何處理PHP文件系統功能中的UTF-8文件名?在PHP的Filesystem functions中處理UTF-8 FileNames 在使用PHP的MKDIR函數中含有UTF-8字符的文件很多flusf-8字符時,您可能會在Windows Explorer中遇到comploreer grounder grounder grounder gro...程式設計 發佈於2025-05-06 -

為什麼使用Firefox後退按鈕時JavaScript執行停止?導航歷史記錄問題:JavaScript使用Firefox Back Back 此行為是由瀏覽器緩存JavaScript資源引起的。要解決此問題並確保在後續頁面訪問中執行腳本,Firefox用戶應設置一個空功能。 警報'); }; alert('inline Alert')...程式設計 發佈於2025-05-06

為什麼使用Firefox後退按鈕時JavaScript執行停止?導航歷史記錄問題:JavaScript使用Firefox Back Back 此行為是由瀏覽器緩存JavaScript資源引起的。要解決此問題並確保在後續頁面訪問中執行腳本,Firefox用戶應設置一個空功能。 警報'); }; alert('inline Alert')...程式設計 發佈於2025-05-06 -

為什麼我在Silverlight Linq查詢中獲得“無法找到查詢模式的實現”錯誤?查詢模式實現缺失:解決“無法找到”錯誤在Silverlight應用程序中,嘗試使用LINQ建立LINQ連接以錯誤而實現的數據庫”,無法找到查詢模式的實現。”當省略LINQ名稱空間或查詢類型缺少IEnumerable 實現時,通常會發生此錯誤。 解決問題來驗證該類型的質量是至關重要的。在此特定實例...程式設計 發佈於2025-05-06

為什麼我在Silverlight Linq查詢中獲得“無法找到查詢模式的實現”錯誤?查詢模式實現缺失:解決“無法找到”錯誤在Silverlight應用程序中,嘗試使用LINQ建立LINQ連接以錯誤而實現的數據庫”,無法找到查詢模式的實現。”當省略LINQ名稱空間或查詢類型缺少IEnumerable 實現時,通常會發生此錯誤。 解決問題來驗證該類型的質量是至關重要的。在此特定實例...程式設計 發佈於2025-05-06 -

如何簡化PHP中的JSON解析以獲取多維陣列?php 試圖在PHP中解析JSON數據的JSON可能具有挑戰性,尤其是在處理多維數組時。 To simplify the process, it's recommended to parse the JSON as an array rather than an object.To do...程式設計 發佈於2025-05-06

如何簡化PHP中的JSON解析以獲取多維陣列?php 試圖在PHP中解析JSON數據的JSON可能具有挑戰性,尤其是在處理多維數組時。 To simplify the process, it's recommended to parse the JSON as an array rather than an object.To do...程式設計 發佈於2025-05-06 -

如何使用Python有效地以相反順序讀取大型文件?在python 反向行讀取器生成器 == ord('\ n'): 緩衝區=緩衝區[:-1] 剩餘_size- = buf_size lines = buffer.split('\ n'....程式設計 發佈於2025-05-06

如何使用Python有效地以相反順序讀取大型文件?在python 反向行讀取器生成器 == ord('\ n'): 緩衝區=緩衝區[:-1] 剩餘_size- = buf_size lines = buffer.split('\ n'....程式設計 發佈於2025-05-06 -

C++20 Consteval函數中模板參數能否依賴於函數參數?[ consteval函數和模板參數依賴於函數參數在C 17中,模板參數不能依賴一個函數參數,因為編譯器仍然需要對非contexexpr futcoriations contim at contexpr function進行評估。 compile time。 C 20引入恆定函數,必須在編譯時進...程式設計 發佈於2025-05-06

C++20 Consteval函數中模板參數能否依賴於函數參數?[ consteval函數和模板參數依賴於函數參數在C 17中,模板參數不能依賴一個函數參數,因為編譯器仍然需要對非contexexpr futcoriations contim at contexpr function進行評估。 compile time。 C 20引入恆定函數,必須在編譯時進...程式設計 發佈於2025-05-06 -

JavaScript計算兩個日期之間天數的方法How to Calculate the Difference Between Dates in JavascriptAs you attempt to determine the difference between two dates in Javascript, consider this s...程式設計 發佈於2025-05-06

JavaScript計算兩個日期之間天數的方法How to Calculate the Difference Between Dates in JavascriptAs you attempt to determine the difference between two dates in Javascript, consider this s...程式設計 發佈於2025-05-06 -

如何在php中使用捲髮發送原始帖子請求?如何使用php 創建請求來發送原始帖子請求,開始使用curl_init()開始初始化curl session。然後,配置以下選項: curlopt_url:請求 [要發送的原始數據指定內容類型,為原始的帖子請求指定身體的內容類型很重要。在這種情況下,它是文本/平原。要執行此操作,請使用包含以下標頭...程式設計 發佈於2025-05-06

如何在php中使用捲髮發送原始帖子請求?如何使用php 創建請求來發送原始帖子請求,開始使用curl_init()開始初始化curl session。然後,配置以下選項: curlopt_url:請求 [要發送的原始數據指定內容類型,為原始的帖子請求指定身體的內容類型很重要。在這種情況下,它是文本/平原。要執行此操作,請使用包含以下標頭...程式設計 發佈於2025-05-06 -

您如何在Laravel Blade模板中定義變量?在Laravel Blade模板中使用Elegance 在blade模板中如何分配變量對於存儲以後使用的數據至關重要。在使用“ {{}}”分配變量的同時,它可能並不總是最優雅的解決方案。 幸運的是,Blade通過@php Directive提供了更優雅的方法: $ old_section =...程式設計 發佈於2025-05-06

您如何在Laravel Blade模板中定義變量?在Laravel Blade模板中使用Elegance 在blade模板中如何分配變量對於存儲以後使用的數據至關重要。在使用“ {{}}”分配變量的同時,它可能並不總是最優雅的解決方案。 幸運的是,Blade通過@php Directive提供了更優雅的方法: $ old_section =...程式設計 發佈於2025-05-06 -

對象擬合:IE和Edge中的封面失敗,如何修復?To resolve this issue, we employ a clever CSS solution that solves the problem:position: absolute;top: 50%;left: 50%;transform: translate(-50%, -50%)...程式設計 發佈於2025-05-06

對象擬合:IE和Edge中的封面失敗,如何修復?To resolve this issue, we employ a clever CSS solution that solves the problem:position: absolute;top: 50%;left: 50%;transform: translate(-50%, -50%)...程式設計 發佈於2025-05-06 -

Async Void vs. Async Task在ASP.NET中:為什麼Async Void方法有時會拋出異常?在ASP.NET async void void async void void void void void的設計無需返回asynchroncon而無需返回任務對象。他們在執行過程中增加未償還操作的計數,並在完成後減少。在某些情況下,這種行為可能是有益的,例如未期望或明確預期操作結果的火災和...程式設計 發佈於2025-05-06

Async Void vs. Async Task在ASP.NET中:為什麼Async Void方法有時會拋出異常?在ASP.NET async void void async void void void void void的設計無需返回asynchroncon而無需返回任務對象。他們在執行過程中增加未償還操作的計數,並在完成後減少。在某些情況下,這種行為可能是有益的,例如未期望或明確預期操作結果的火災和...程式設計 發佈於2025-05-06 -

版本5.6.5之前,使用current_timestamp與時間戳列的current_timestamp與時間戳列有什麼限制?在時間戳列上使用current_timestamp或MySQL版本中的current_timestamp或在5.6.5 此限制源於遺留實現的關注,這些限制需要對當前的_timestamp功能進行特定的實現。 創建表`foo`( `Productid` int(10)unsigned not ...程式設計 發佈於2025-05-06

版本5.6.5之前,使用current_timestamp與時間戳列的current_timestamp與時間戳列有什麼限制?在時間戳列上使用current_timestamp或MySQL版本中的current_timestamp或在5.6.5 此限制源於遺留實現的關注,這些限制需要對當前的_timestamp功能進行特定的實現。 創建表`foo`( `Productid` int(10)unsigned not ...程式設計 發佈於2025-05-06 -

為什麼Microsoft Visual C ++無法正確實現兩台模板的實例?The Mystery of "Broken" Two-Phase Template Instantiation in Microsoft Visual C Problem Statement:Users commonly express concerns that Micro...程式設計 發佈於2025-05-06

為什麼Microsoft Visual C ++無法正確實現兩台模板的實例?The Mystery of "Broken" Two-Phase Template Instantiation in Microsoft Visual C Problem Statement:Users commonly express concerns that Micro...程式設計 發佈於2025-05-06 -

如何在鼠標單擊時編程選擇DIV中的所有文本?在鼠標上選擇div文本單擊帶有文本內容,用戶如何使用單個鼠標單擊單擊div中的整個文本?這允許用戶輕鬆拖放所選的文本或直接複製它。 在單個鼠標上單擊的div元素中選擇文本,您可以使用以下Javascript函數: function selecttext(canduterid){ if(d...程式設計 發佈於2025-05-06

如何在鼠標單擊時編程選擇DIV中的所有文本?在鼠標上選擇div文本單擊帶有文本內容,用戶如何使用單個鼠標單擊單擊div中的整個文本?這允許用戶輕鬆拖放所選的文本或直接複製它。 在單個鼠標上單擊的div元素中選擇文本,您可以使用以下Javascript函數: function selecttext(canduterid){ if(d...程式設計 發佈於2025-05-06

學習中文

- 1 走路用中文怎麼說? 走路中文發音,走路中文學習

- 2 坐飛機用中文怎麼說? 坐飞机中文發音,坐飞机中文學習

- 3 坐火車用中文怎麼說? 坐火车中文發音,坐火车中文學習

- 4 坐車用中文怎麼說? 坐车中文發音,坐车中文學習

- 5 開車用中文怎麼說? 开车中文發音,开车中文學習

- 6 游泳用中文怎麼說? 游泳中文發音,游泳中文學習

- 7 騎自行車用中文怎麼說? 骑自行车中文發音,骑自行车中文學習

- 8 你好用中文怎麼說? 你好中文發音,你好中文學習

- 9 謝謝用中文怎麼說? 谢谢中文發音,谢谢中文學習

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning