титульная страница > программирование > Golang: как наблюдаемость и профилирование выявили почти необнаружимое троттлинг

титульная страница > программирование > Golang: как наблюдаемость и профилирование выявили почти необнаружимое троттлинг

Golang: как наблюдаемость и профилирование выявили почти необнаружимое троттлинг

В личном проекте Go, который получает информацию о финансовых активах от Bovespa.

Система интенсивно использует параллелизм и параллелизм с горутинами, обновляя информацию об активах (наряду с бизнес-расчетами) каждые 8 секунд.

Первоначально никаких ошибок или предупреждений не появлялось, но я заметил, что некоторые горутины выполнялись дольше, чем другие.

Если быть более конкретным, то время p99 составляло 0,03 мс, в некоторые моменты оно увеличивалось до 0,9 мс. Это побудило меня глубже изучить проблему.

Я обнаружил, что использую пул горутин семафоров, который был создан на основе переменной GOMAXPROCS.

Однако я понял, что в этом подходе есть проблема.

Когда мы используем переменную GOMAXPROCS, она неправильно фиксирует количество ядер, доступных в контейнере. Если в контейнере доступно меньше ядер, чем общее количество виртуальной машины, учитывается общее количество виртуальных машин. Например, у моей виртуальной машины есть 8 доступных ядер, но в контейнере их было только 4. В результате было создано 8 горутин для одновременной работы, что вызвало регулирование.

После долгих исследований за ночь я нашел библиотеку, разработанную Uber, которая более эффективно автоматически настраивает переменную GOMAXPROCS, независимо от того, находится она в контейнере или нет. Это решение оказалось чрезвычайно стабильным и эффективным: automaxprocs

убер-гоу

/

автомакспрокс

убер-гоу

/

автомакспрокс

Автоматически настройте GOMAXPROCS в соответствии с квотой процессора контейнера Linux.

automaxprocs

Автоматически устанавливать GOMAXPROCS в соответствии с квотой процессора контейнера Linux.

Установка

go get -u go.uber.org/automaxprocs

Быстрый старт

import _ "go.uber.org/automaxprocs"

func main() {

// Your application logic here.

}

Производительность

Данные получены с помощью внутреннего балансировщика нагрузки Uber. Мы запустили балансировщик нагрузки с квотой ЦП 200 % (т. е. с 2 ядрами):

| GOMAXPROCS | RPS | P50 (мс) | P99,9 (мс) |

|---|---|---|---|

| 1 | 28 893,18 | 1,46 | 19,70 |

| 2 (равен квоте) | 44 715,07 | 0,84 | 26,38 |

| 3 | 44 212,93 | 0,66 | 30.07 |

| 4 | 41 071,15 | 0,57 | 42,94 |

| 8 | 33 111,69 | 0,43 | 64,32 |

| По умолчанию (24) | 22 191,40 | 0,45 | 76,19 |

Когда GOMAXPROCS увеличивается сверх квоты ЦП, мы видим незначительное уменьшение P50, но значительное увеличение до P99. Мы также видим, что общее количество обработанных запросов в секунду также уменьшается.

Когда GOMAXPROCS превышает выделенную квоту ЦП, мы также наблюдаем значительное регулирование:

$ cat /sys/fs/cgroup/cpu,cpuacct/system.slice/[...]/cpu.stat nr_periods 42227334 nr_throttled 131923 throttled_time 88613212216618

После того как GOMAXPROCS был уменьшен в соответствии с квотой ЦП, мы не заметили регулирования ЦП.

После реализации использования этой библиотеки проблема решилась, и теперь время p99 оставалось постоянно на уровне 0,02 мс. Этот опыт подчеркнул важность наблюдаемости и профилирования в параллельных системах.

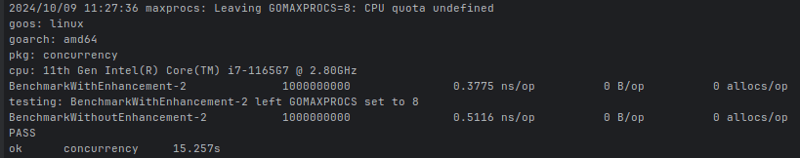

Ниже приведен очень простой пример, но демонстрирующий разницу в производительности.

Используя встроенное тестирование Go и пакет benckmak, я создал два файла:

benchmarking_with_enhancement_test.go:

package main

import (

_ "go.uber.org/automaxprocs"

"runtime"

"sync"

"testing"

)

// BenchmarkWithEnhancement Função com melhoria, para adicionar o indice do loop em um array de inteiro

func BenchmarkWithEnhancement(b *testing.B) {

// Obtém o número de CPUs disponíveis

numCPUs := runtime.NumCPU()

// Define o máximo de CPUs para serem usadas pelo programa

maxGoroutines := runtime.GOMAXPROCS(numCPUs)

// Criação do semáforo

semaphore := make(chan struct{}, maxGoroutines)

var (

// Espera para grupo de goroutines finalizar

wg sync.WaitGroup

// Propriade

mu sync.Mutex

// Lista para armazenar inteiros

list []int

)

// Loop com mihão de indices

for i := 0; i

benchmarking_without_enhancement_test.go:

package main

import (

"runtime"

"sync"

"testing"

)

// BenchmarkWithoutEnhancement Função sem a melhoria, para adicionar o indice do loop em um array de inteiro

func BenchmarkWithoutEnhancement(b *testing.B) {

// Obtém o número de CPUs disponíveis

numCPUs := runtime.NumCPU()

// Define o máximo de CPUs para serem usadas pelo programa

maxGoroutines := runtime.GOMAXPROCS(numCPUs)

// Criação do semáforo

semaphore := make(chan struct{}, maxGoroutines)

var (

// Espera para grupo de goroutines finalizar

wg sync.WaitGroup

// Propriade

mu sync.Mutex

// Lista para armazenar inteiros

list []int

)

// Loop com mihão de indices

for i := 0; i

Разница между ними в том, что используется импорт библиотеки Uber.

При запуске теста, предполагая, что будут использоваться 2 процессора, результат был следующим:

ns/op: показывает среднее время в наносекундах, необходимое для выполнения определенной операции.

Обратите внимание, что общее количество доступных процессоров составляет 8 ядер, и именно это возвращает свойство runtime.NumCPU(). Однако, как и при запуске теста, я определил, что будут использоваться только два процессора, а файл, который не использовал automaxprocs, определил, что предел выполнения за раз будет 8 горутин, а наиболее эффективным будет 2, потому что таким образом, использование меньшего количества ресурсов делает выполнение более эффективным.

Итак, важность наблюдения и профилирования наших приложений очевидна.

-

FOSTAPI CUSTEM 404 Руководство по созданию страницCustom 404 не найдена страницей с FastApi , чтобы создать пользовательскую страницу 404, не найденная, FastApi предлагает несколько подходов. С...программирование Опубликовано в 2025-07-13

FOSTAPI CUSTEM 404 Руководство по созданию страницCustom 404 не найдена страницей с FastApi , чтобы создать пользовательскую страницу 404, не найденная, FastApi предлагает несколько подходов. С...программирование Опубликовано в 2025-07-13 -

Как я могу безопасно объединить текст и значения при построении запросов SQL в Go?incatenating text и values в go sql Queries при конструкции текста SQL -запроса в Go существуют определенные правила синтаксиса, при которых с...программирование Опубликовано в 2025-07-13

Как я могу безопасно объединить текст и значения при построении запросов SQL в Go?incatenating text и values в go sql Queries при конструкции текста SQL -запроса в Go существуют определенные правила синтаксиса, при которых с...программирование Опубликовано в 2025-07-13 -

Почему HTML не может печатать номера и решения страницне может печатать номера страниц на HTML Pages? задача Описание: , несмотря на широкое исследование, номера страниц не появляются при печати h...программирование Опубликовано в 2025-07-13

Почему HTML не может печатать номера и решения страницне может печатать номера страниц на HTML Pages? задача Описание: , несмотря на широкое исследование, номера страниц не появляются при печати h...программирование Опубликовано в 2025-07-13 -

Как я могу поддерживать пользовательский рендеринг JTable Cell после редактирования ячейки?поддержание рендеринга Jtable Cell после редактирования ячейки в jtable, реализация пользовательских элементов рендеринга ячейки и редактирова...программирование Опубликовано в 2025-07-13

Как я могу поддерживать пользовательский рендеринг JTable Cell после редактирования ячейки?поддержание рендеринга Jtable Cell после редактирования ячейки в jtable, реализация пользовательских элементов рендеринга ячейки и редактирова...программирование Опубликовано в 2025-07-13 -

Разрешить исключение \\ "Ошибка строкового значения \\"разрешение исключения неверного строкового значения при вставке эмоджи при попытке вставить строку, содержащую символы эмоджи в базу данных mysq...программирование Опубликовано в 2025-07-13

Разрешить исключение \\ "Ошибка строкового значения \\"разрешение исключения неверного строкового значения при вставке эмоджи при попытке вставить строку, содержащую символы эмоджи в базу данных mysq...программирование Опубликовано в 2025-07-13 -

Как эффективно повторить строковые символы для вдавления в C#?повторяя строку для вдавления , когда обрабатывает строку, основанную на глубине элемента, удобно иметь эффективный способ вернуть строку, повт...программирование Опубликовано в 2025-07-13

Как эффективно повторить строковые символы для вдавления в C#?повторяя строку для вдавления , когда обрабатывает строку, основанную на глубине элемента, удобно иметь эффективный способ вернуть строку, повт...программирование Опубликовано в 2025-07-13 -

Почему изображения все еще имеют границы в Chrome? `Граница: нет;` НЕПРАВИЛЬНОЕ РЕШЕНИЕ] Удаление границы изображения в Chrome . Одна частая проблема, встречающаяся при работе с изображениями в Chrome, и IE9 - это появление постоян...программирование Опубликовано в 2025-07-13

Почему изображения все еще имеют границы в Chrome? `Граница: нет;` НЕПРАВИЛЬНОЕ РЕШЕНИЕ] Удаление границы изображения в Chrome . Одна частая проблема, встречающаяся при работе с изображениями в Chrome, и IE9 - это появление постоян...программирование Опубликовано в 2025-07-13 -

Какой метод более эффективен для обнаружения с точки зрения полигона: трассировка лучей или matplotlib \ path.contains_points?эффективное обнаружение с пунктом-в полигоне в Python определение того, находится ли точка в полигоне частой задачей в вычислительной геометрии....программирование Опубликовано в 2025-07-13

Какой метод более эффективен для обнаружения с точки зрения полигона: трассировка лучей или matplotlib \ path.contains_points?эффективное обнаружение с пунктом-в полигоне в Python определение того, находится ли точка в полигоне частой задачей в вычислительной геометрии....программирование Опубликовано в 2025-07-13 -

Как правильно вставить Blobs (изображения) в MySQL с помощью PHP?вставьте Blobs в базы данных MySQL с PHP При попытке сохранить изображение в базе данных MySQL, вы можете столкнуться с проблемой. Это руково...программирование Опубликовано в 2025-07-13

Как правильно вставить Blobs (изображения) в MySQL с помощью PHP?вставьте Blobs в базы данных MySQL с PHP При попытке сохранить изображение в базе данных MySQL, вы можете столкнуться с проблемой. Это руково...программирование Опубликовано в 2025-07-13 -

Разница между перегрузкой функций PHP и C ++PHP Функция перегрузка: разворачивание Enigma с точки зрения A C как опытный разработчик C, выходящего на сферу PHP, вы можете столкнуться с пон...программирование Опубликовано в 2025-07-13

Разница между перегрузкой функций PHP и C ++PHP Функция перегрузка: разворачивание Enigma с точки зрения A C как опытный разработчик C, выходящего на сферу PHP, вы можете столкнуться с пон...программирование Опубликовано в 2025-07-13 -

Как реализовать универсальную хэш -функцию для кортежей в неупорядоченных коллекциях?generic hash function для кортежей в неупорядоченных коллекциях . Чтобы исправить это, один подход - это вручную определить функцию HASH для к...программирование Опубликовано в 2025-07-13

Как реализовать универсальную хэш -функцию для кортежей в неупорядоченных коллекциях?generic hash function для кортежей в неупорядоченных коллекциях . Чтобы исправить это, один подход - это вручную определить функцию HASH для к...программирование Опубликовано в 2025-07-13 -

Как сортировать ключи от Javascript объекта в алфавитном порядке?Как сортировать объекты javascript по Key Если у вас есть объект JavaScript, вы можете реорганизовать его свойства алфавитно для улучшенных це...программирование Опубликовано в 2025-07-13

Как сортировать ключи от Javascript объекта в алфавитном порядке?Как сортировать объекты javascript по Key Если у вас есть объект JavaScript, вы можете реорганизовать его свойства алфавитно для улучшенных це...программирование Опубликовано в 2025-07-13 -

Множествометоды являются FNS, которые можно вызвать на Objects ] Массивы являются объектами, следовательно, они также имеют методы в JS. ] ] Срез (...программирование Опубликовано в 2025-07-13

Множествометоды являются FNS, которые можно вызвать на Objects ] Массивы являются объектами, следовательно, они также имеют методы в JS. ] ] Срез (...программирование Опубликовано в 2025-07-13 -

Как я могу эффективно получить значения атрибутов из файлов XML с помощью PHP?получение значений атрибутов из файлов XML в php каждый разработчик сталкивается с необходимостью проанализировать файлы XML и извлекать опред...программирование Опубликовано в 2025-07-13

Как я могу эффективно получить значения атрибутов из файлов XML с помощью PHP?получение значений атрибутов из файлов XML в php каждый разработчик сталкивается с необходимостью проанализировать файлы XML и извлекать опред...программирование Опубликовано в 2025-07-13 -

Как динамически обнаружить типы пакетов экспорта на языке GO?поиск экспортированных типов пакетов динамически ] в отличие от возможностей обнаружения ограниченного типа в пакете отражения, эта статья иссл...программирование Опубликовано в 2025-07-13

Как динамически обнаружить типы пакетов экспорта на языке GO?поиск экспортированных типов пакетов динамически ] в отличие от возможностей обнаружения ограниченного типа в пакете отражения, эта статья иссл...программирование Опубликовано в 2025-07-13

Изучайте китайский

- 1 Как сказать «гулять» по-китайски? 走路 Китайское произношение, 走路 Изучение китайского языка

- 2 Как сказать «Сесть на самолет» по-китайски? 坐飞机 Китайское произношение, 坐飞机 Изучение китайского языка

- 3 Как сказать «сесть на поезд» по-китайски? 坐火车 Китайское произношение, 坐火车 Изучение китайского языка

- 4 Как сказать «поехать на автобусе» по-китайски? 坐车 Китайское произношение, 坐车 Изучение китайского языка

- 5 Как сказать «Ездить» по-китайски? 开车 Китайское произношение, 开车 Изучение китайского языка

- 6 Как будет плавание по-китайски? 游泳 Китайское произношение, 游泳 Изучение китайского языка

- 7 Как сказать «кататься на велосипеде» по-китайски? 骑自行车 Китайское произношение, 骑自行车 Изучение китайского языка

- 8 Как поздороваться по-китайски? 你好Китайское произношение, 你好Изучение китайского языка

- 9 Как сказать спасибо по-китайски? 谢谢Китайское произношение, 谢谢Изучение китайского языка

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning