API Gemini: o nível gratuito que deixa os desenvolvedores felizes

GPT é demais, mas não oferece mais uma API com nível gratuito – pelo menos não mais. Felizmente, o Google faz isso, com Gemini API e Studio AI (a versão do ChatGPT do Google).

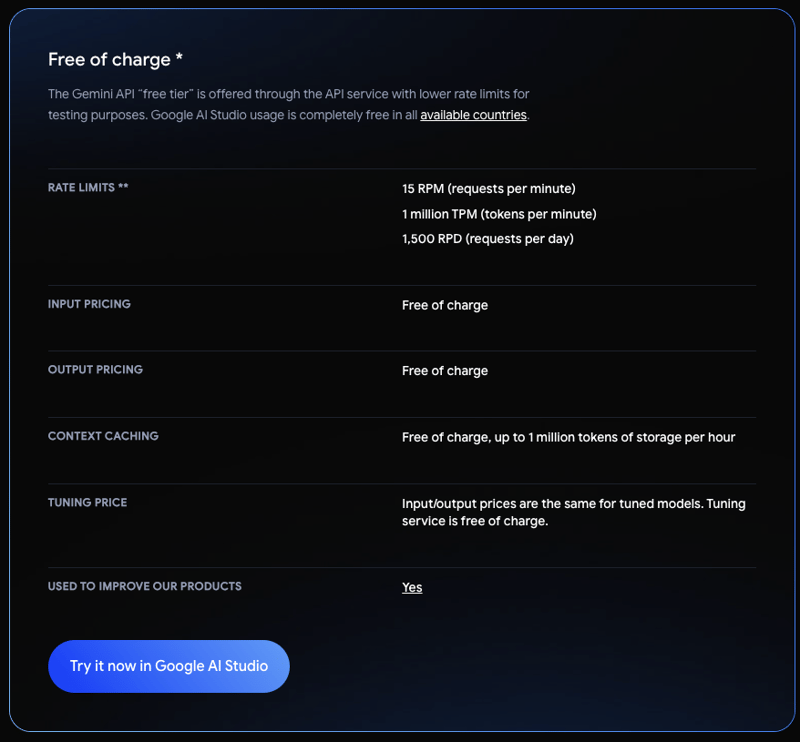

No momento em que este artigo foi escrito, aqui está o que o nível gratuito da API Gemini oferece:

Como você pode ver, isso é mais que suficiente para começar a brincar com a API, então não há desculpa para não integrá-la em nossos projetos.

O guia de início rápido é super direto.

No meu caso, estou usando o Gemini para uma tarefa bastante inútil, mas o objetivo é mostrar como é fácil integrar sua API.

Confira o trecho a seguir, que gera "citações engraçadas" com base em um número de popularidade.

const { GoogleGenerativeAI } = require("@google/generative-ai");

const genAI = new GoogleGenerativeAI(process.env.GEMINI_API_KEY);

const model = genAI.getGenerativeModel({ model: "gemini-1.5-flash" });

const popularity = 42;

const prompt = `Write a funny quote, under 200 characters, about popularity on a scale from 0 to 100, where 0 is the least popular and 100 is the most. The quote should describe someone at ${popularity}.`;

const result = await model.generateContent(prompt);

console.log(result);

Saída:

É isso! Algumas coisas a serem observadas:Ele tem um sólido 42º lugar na escala de popularidade. Não é exatamente 'legal', mas definitivamente não é 'aquele cara com quem ninguém fala'.

- Observe como uma variável de ambiente API_KEY é necessária. Você pode obtê-lo no AI Studio assim que sua conta estiver configurada.

- O modelo selecionado é gemini-1.5-flash. O Studio AI oferece vários modelos, para que você possa experimentar diferentes para encontrar o melhor ajuste.

- O resto é apenas JavaScript normal, passando um prompt para o método generateContent e registrando o resultado.

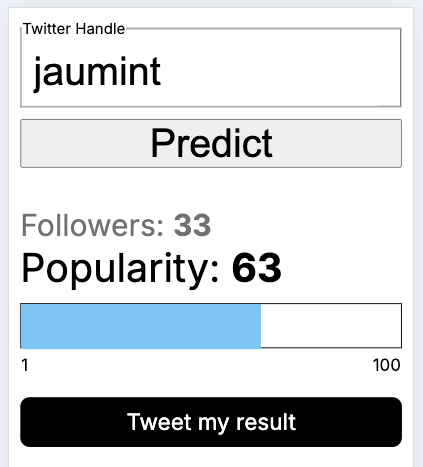

Em minha postagem anterior, TensorFlow: From Python to JavaScript, compartilhei uma demonstração que prevê a popularidade de uma conta do Twitter. Fique à vontade para conferir e, se clicar em "Tweetar meu resultado", será gerado um tweet usando o snippet acima.

- IU:

- Tweet:

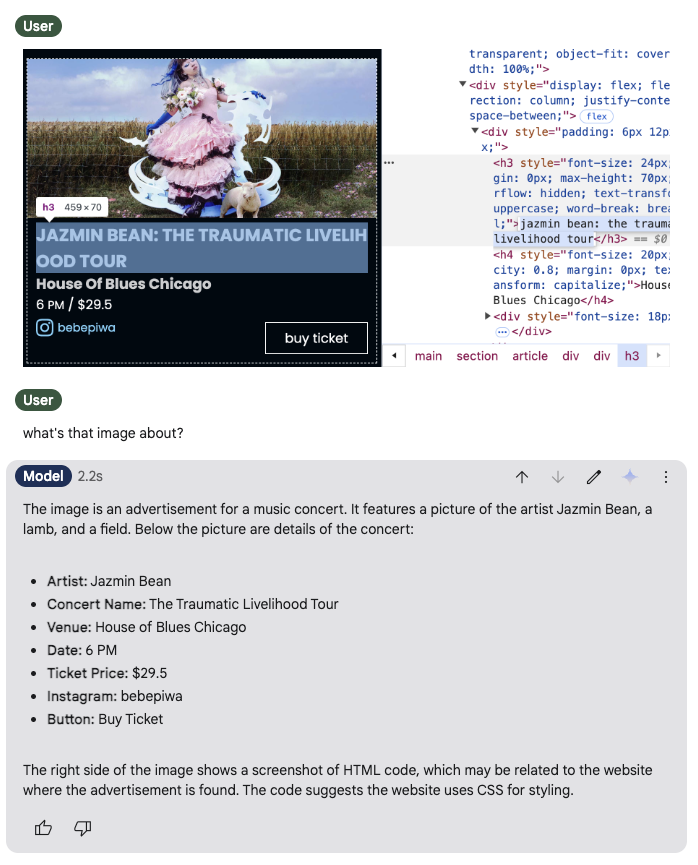

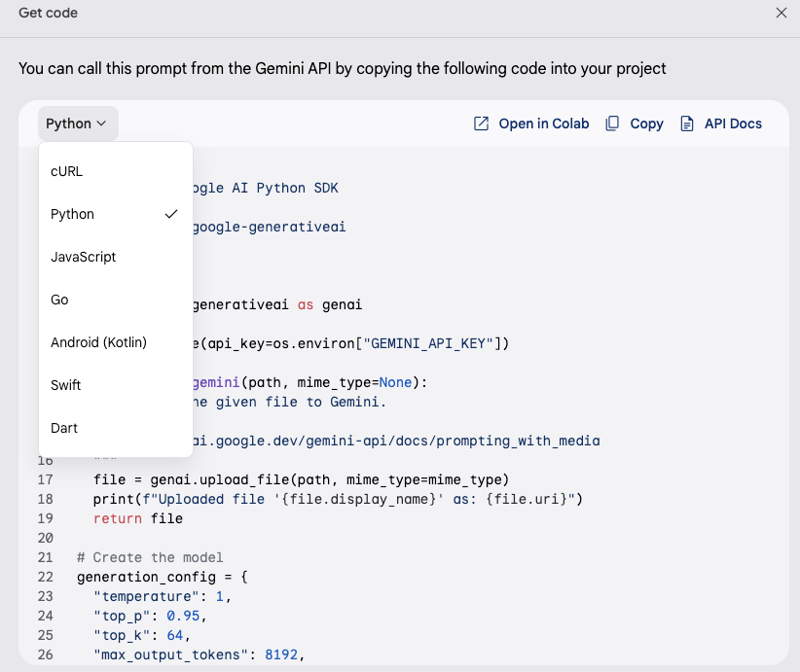

Obtenha recurso de código no Studio AI

Além disso, o Google oferece o Studio AI, que é semelhante ao ChatGPT, mas com um recurso interessante: Get Code. Você pode inserir um prompt e, se for o que deseja para o seu serviço, basta clicar no botão e ele fornecerá o código necessário para executar o mesmo prompt a partir do seu próprio código.

- Comando:

- Obter código:

Sou um grande fã do ChatGPT, mas como desenvolvedor, achei o nível gratuito do Studio AI muito útil. Para experimentação, o OpenAI não é muito caro, mas nada supera um nível gratuito. Ambos possuem documentação sólida.

Na minha humilde opinião, o GPT ainda dá respostas melhores do que o Gemini, mas nos estágios iniciais de um projeto, eu escolheria o Gemini e mudaria para o GPT quando a precisão se tornasse crítica e o investimento fizesse sentido.

Enquanto isso, eu seguiria um padrão de proxy, portanto, se a mudança for necessária, será uma tarefa fácil.

Vamos dar uma olhada no seguinte trecho:

const { GoogleGenerativeAI } = require("@google/generative-ai");

async function getJokeFromGenerativeAI() {

const genAI = new GoogleGenerativeAI(process.env.GEMINI_API_KEY);

const model = genAI.getGenerativeModel({ model: "gemini-1.5-flash" });

const popularity = 42;

const prompt = `Write a funny quote, under 200 characters, about popularity on a scale from 0 to 100, where 0 is the least popular and 100 is the most. The quote should describe someone at ${popularity}.`;

const result = await model.generateContent(prompt);

return result;

}

// proxy

async function getJoke() {

const joke = await getJokeFromGenerativeAI();

return joke;

}

Dessa forma, os consumidores podem chamar getJoke() sem se preocupar com o que está acontecendo nos bastidores. Conforme o tempo passa, e digamos que o GPT seja necessário, a mudança se torna simples:

const { GoogleGenerativeAI } = require("@google/generative-ai");

async function getJokeFromGenerativeAI() {

const genAI = new GoogleGenerativeAI(process.env.GEMINI_API_KEY);

const model = genAI.getGenerativeModel({ model: "gemini-1.5-flash" });

const popularity = 42;

const prompt = `Write a funny quote, under 200 characters, about popularity on a scale from 0 to 100, where 0 is the least popular and 100 is the most. The quote should describe someone at ${popularity}.`;

const result = await model.generateContent(prompt);

return result;

}

// proxy

async function getJoke() {

const joke = await getJokeFromGenerativeAI();

return joke;

}

Observe como getJoke agora chama o novo método: getJokeFromOpenAI. Como ambos os métodos seguem o mesmo contrato —ambos retornam uma Promise que se transforma em uma string—os consumidores de getJoke não notarão a mudança e não precisarão atualizar nada.

Documentos OpenAIConclusão

Todos os dias, mais aplicativos integram IA, a ponto de os usuários começarem a esperar por isso, assim como esperam sites rápidos e fáceis de usar. Como desenvolvedor, é importante conhecer as opções disponíveis: modelo personalizado, modelo de código aberto e modelo privado, e aproveitá-las a nosso favor. Quem sabe o que vem a seguir, mas seja o que for, certamente será construído sobre os ombros da IA.

-

Por que há listras no meu fundo linear de gradiente e como posso consertá -las?banindo as faixas de fundo do gradiente linear Ao empregar a propriedade linear de gradiente para um plano de fundo, você pode encontrar listr...Programação Postado em 2025-06-09

Por que há listras no meu fundo linear de gradiente e como posso consertá -las?banindo as faixas de fundo do gradiente linear Ao empregar a propriedade linear de gradiente para um plano de fundo, você pode encontrar listr...Programação Postado em 2025-06-09 -

Como verificar se um objeto tem um atributo específico no Python?Método para determinar o atributo de objeto Existence Esta consulta busca um método para verificar a presença de um atributo específico em um ...Programação Postado em 2025-06-09

Como verificar se um objeto tem um atributo específico no Python?Método para determinar o atributo de objeto Existence Esta consulta busca um método para verificar a presença de um atributo específico em um ...Programação Postado em 2025-06-09 -

Como analisar números na notação exponencial usando decimal.parse ()?analisando um número da notação exponencial ao tentar analisar uma string expressa em anotação exponencial usando Decimal.parse ("1.2345e...Programação Postado em 2025-06-09

Como analisar números na notação exponencial usando decimal.parse ()?analisando um número da notação exponencial ao tentar analisar uma string expressa em anotação exponencial usando Decimal.parse ("1.2345e...Programação Postado em 2025-06-09 -

Como superar as restrições de redefinição da função do PHP?superando a função do PHP Redefinição limitações em php, definir uma função com o mesmo nome várias vezes é um não-no. Tentar fazê -lo, como v...Programação Postado em 2025-06-09

Como superar as restrições de redefinição da função do PHP?superando a função do PHP Redefinição limitações em php, definir uma função com o mesmo nome várias vezes é um não-no. Tentar fazê -lo, como v...Programação Postado em 2025-06-09 -

Como posso substituir com eficiência várias substringas em uma string java?substituindo várias substâncias em uma string com eficiência em java quando confrontado com a necessidade de substituir várias substringas den...Programação Postado em 2025-06-09

Como posso substituir com eficiência várias substringas em uma string java?substituindo várias substâncias em uma string com eficiência em java quando confrontado com a necessidade de substituir várias substringas den...Programação Postado em 2025-06-09 -

Tarefa assíncroada vs. assíncrona em asp.net: Por que o método assíncrono void às vezes joga exceções?Entendendo a distinção entre a tarefa assíncrona e async em asp.net em ASP.NET APLICAÇÕES, ASYNCHRONOUS PROGRATIONS APRESENCIA UM REMAÇÃO CRUC...Programação Postado em 2025-06-09

Tarefa assíncroada vs. assíncrona em asp.net: Por que o método assíncrono void às vezes joga exceções?Entendendo a distinção entre a tarefa assíncrona e async em asp.net em ASP.NET APLICAÇÕES, ASYNCHRONOUS PROGRATIONS APRESENCIA UM REMAÇÃO CRUC...Programação Postado em 2025-06-09 -

Como evitar vazamentos de memória ao fatiar a linguagem?vazamento de memória em go slies Compreendendo os vazamentos de memória nas fatias Go pode ser um desafio. Este artigo tem como objetivo forne...Programação Postado em 2025-06-09

Como evitar vazamentos de memória ao fatiar a linguagem?vazamento de memória em go slies Compreendendo os vazamentos de memória nas fatias Go pode ser um desafio. Este artigo tem como objetivo forne...Programação Postado em 2025-06-09 -

Como posso concatenar com segurança o texto e os valores ao construir consultas SQL em Go?concatenando texto e valores em go sql Queries Ao construir uma consulta SQL texth e, em codificação, e a signa e a consulta de syntax e a sín...Programação Postado em 2025-06-09

Como posso concatenar com segurança o texto e os valores ao construir consultas SQL em Go?concatenando texto e valores em go sql Queries Ao construir uma consulta SQL texth e, em codificação, e a signa e a consulta de syntax e a sín...Programação Postado em 2025-06-09 -

Por que o HTML não pode imprimir números de página e soluçõesnão é possível imprimir números de página nas páginas html? Usado: @página { margem: 10%; @top center { Font-Family: Sans-Serif; Pes...Programação Postado em 2025-06-09

Por que o HTML não pode imprimir números de página e soluçõesnão é possível imprimir números de página nas páginas html? Usado: @página { margem: 10%; @top center { Font-Family: Sans-Serif; Pes...Programação Postado em 2025-06-09 -

Como corrigir \ "mysql_config não encontrou um erro \" ao instalar o mysql-python no ubuntu/linux?MySQL-Python Erro de instalação: "mysql_config não encontrado" tentando um erro indicador que "sQl-python na caixa ubuntu/linux...Programação Postado em 2025-06-09

Como corrigir \ "mysql_config não encontrou um erro \" ao instalar o mysql-python no ubuntu/linux?MySQL-Python Erro de instalação: "mysql_config não encontrado" tentando um erro indicador que "sQl-python na caixa ubuntu/linux...Programação Postado em 2025-06-09 -

Eval () vs. AST.LITERAL_EVAL (): Qual função Python é mais segura para a entrada do usuário?pesando avaliação () e ast.literal_eval () na python Security Ao lidar com a entrada do usuário, é imperativo priorizar a segurança. Eval (), ...Programação Postado em 2025-06-09

Eval () vs. AST.LITERAL_EVAL (): Qual função Python é mais segura para a entrada do usuário?pesando avaliação () e ast.literal_eval () na python Security Ao lidar com a entrada do usuário, é imperativo priorizar a segurança. Eval (), ...Programação Postado em 2025-06-09 -

Qual é a diferença entre funções aninhadas e fechamentos em Pythonfunções aninhadas vs. fechamentos em python enquanto as funções aninhadas em python se assemelham superficialmente, e são fundamentalmente dis...Programação Postado em 2025-06-09

Qual é a diferença entre funções aninhadas e fechamentos em Pythonfunções aninhadas vs. fechamentos em python enquanto as funções aninhadas em python se assemelham superficialmente, e são fundamentalmente dis...Programação Postado em 2025-06-09 -

Como posso personalizar otimizações de compilação no compilador Go?personalizando otimizações de compilação no Go Compiler O processo de compilação padrão em Go segue uma estratégia de otimização específica. N...Programação Postado em 2025-06-09

Como posso personalizar otimizações de compilação no compilador Go?personalizando otimizações de compilação no Go Compiler O processo de compilação padrão em Go segue uma estratégia de otimização específica. N...Programação Postado em 2025-06-09 -

Como localizar a imagem de fundo CSS da direita?posicionar a imagem de fundo da direita com css no reino do desenvolvimento da web, geralmente é desejável posicionar com precisão imagens de ...Programação Postado em 2025-06-09

Como localizar a imagem de fundo CSS da direita?posicionar a imagem de fundo da direita com css no reino do desenvolvimento da web, geralmente é desejável posicionar com precisão imagens de ...Programação Postado em 2025-06-09 -

Quando usar "tente" em vez de "se" para detectar valores variáveis no python?usando "Try" vs. "se" para testar o valor da variável no python no python, há situações em que você pode precisar verificar ...Programação Postado em 2025-06-09

Quando usar "tente" em vez de "se" para detectar valores variáveis no python?usando "Try" vs. "se" para testar o valor da variável no python no python, há situações em que você pode precisar verificar ...Programação Postado em 2025-06-09

Estude chinês

- 1 Como se diz “andar” em chinês? 走路 Pronúncia chinesa, 走路 aprendizagem chinesa

- 2 Como se diz “pegar um avião” em chinês? 坐飞机 Pronúncia chinesa, 坐飞机 aprendizagem chinesa

- 3 Como se diz “pegar um trem” em chinês? 坐火车 Pronúncia chinesa, 坐火车 aprendizagem chinesa

- 4 Como se diz “pegar um ônibus” em chinês? 坐车 Pronúncia chinesa, 坐车 aprendizagem chinesa

- 5 Como se diz dirigir em chinês? 开车 Pronúncia chinesa, 开车 aprendizagem chinesa

- 6 Como se diz nadar em chinês? 游泳 Pronúncia chinesa, 游泳 aprendizagem chinesa

- 7 Como se diz andar de bicicleta em chinês? 骑自行车 Pronúncia chinesa, 骑自行车 aprendizagem chinesa

- 8 Como você diz olá em chinês? 你好Pronúncia chinesa, 你好Aprendizagem chinesa

- 9 Como você agradece em chinês? 谢谢Pronúncia chinesa, 谢谢Aprendizagem chinesa

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning