ロード バランサーとは何ですか? 受信リクエストをどのように分散するのですか?

Web アプリケーションと分散システムの世界では、ロード バランサーは最適なパフォーマンス、高可用性、およびスケーラビリティを確保する上で重要な役割を果たします。この包括的なガイドでは、ロード バランサーの複雑さを掘り下げ、その目的、種類、構成、ベスト プラクティスを探ります。基本を理解したい初心者でも、システム アーキテクチャの最適化を目指す経験豊富な開発者でも、この記事は負荷分散の世界についての貴重な洞察を提供します。

ロードバランサーとは何ですか?

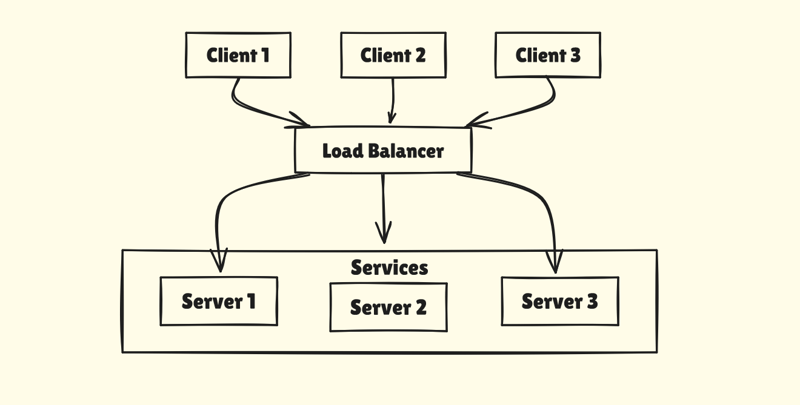

ロード バランサーは、ネットワークまたはアプリケーションのトラフィックを複数のサーバーに分散するデバイスまたはソフトウェアです。ロード バランサーはリクエストを均等に分散することで、単一のサーバーが過負荷にならないようにし、アプリケーションの信頼性とパフォーマンスを向上させます。

目的と機能

ロード バランサーは、アプリケーションの交通警察として機能する、システム アーキテクチャの重要なコンポーネントです。その主な目的は、受信ネットワーク トラフィックを複数のサーバーに分散し、単一のサーバーが過剰な要求を負担しないようにすることです。ワークロードを分散することで、ロード バランサは次のことに役立ちます:

- アプリケーションの応答性を向上させます

- 可用性と信頼性の向上

- サーバーの過負荷を防ぐ

- アプリケーションのスケーリングを容易にする

ロードバランサーがトラフィックを分散する方法

ロード バランサーは、さまざまなアルゴリズムを使用して、受信リクエストを分散する方法を決定します。一般的なメソッドには次のものがあります:

- ラウンドロビン: リクエストは各サーバーに順番に分散されます。

- 最小接続数: トラフィックは、アクティブな接続数が最も少ないサーバーに送信されます。

- IP ハッシュ: クライアントの IP アドレスは、どのサーバーがリクエストを受信するかを決定するために使用され、クライアントが常に同じサーバーに接続するようにします。

- 加重ラウンドロビン: サーバーには、その機能に基づいて異なる重みが割り当てられ、リクエストの分散に影響します。

Client Request

|

Load Balancer Receives Request

|

Select Appropriate Server (Based on Algorithm)

|

Forward Request to Selected Server

|

Server Processes Request

|

Send Response Back to Client

基本構成

ロード バランシング用の人気のオープンソース ソフトウェアである Nginx を使用して、シンプルなロード バランサをセットアップしてみましょう。

Nginx のインストール:

`bash` sudo apt-get update sudo apt-get install nginx

Nginx をロード バランサーとして構成する:

nginx.conf ファイルを編集して次の内容を含めます:

nginx

http {

upstream backend {

server server1.example.com;

server server2.example.com;

server server3.example.com;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}

}

ロード バランサーをテストします。

- Nginx の開始: sudo サービス nginx 開始

- ロード バランサーの IP アドレスにリクエストを送信します。リクエストがserver1.example.com、server2.example.com、およびserver3.example.comに分散されていることがわかります。

構成プロセス

- ロード バランサーの選択: ニーズに基づいてハードウェア デバイスまたはソフトウェア ソリューションを選択します。

- バックエンド サーバーの定義: トラフィックを受信するサーバーのプールを指定します。

- リスニング ポートの構成: ロード バランサーが受信トラフィックを受信するポートを設定します。

- ルーティング ルールのセットアップ: トラフィックをバックエンド サーバーに分散する方法を定義します。

- ヘルス チェックの構成: バックエンド サーバーが動作していることを確認するチェックを実装します。

重要な構成設定

- 負荷分散アルゴリズム: トラフィックを分散する方法を選択します (ラウンド ロビン、最小接続など)。

- セッションの永続性: 特定のサーバー上でユーザー セッションを維持するかどうか、および維持する方法を決定します。

- SSL/TLS 設定: ロードバランサーで SSL を終了する場合の暗号化設定を構成します。

- ログとモニタリング: パフォーマンスを追跡し、問題のトラブルシューティングを行うためにログを設定します。

サーバーのヘルスチェック

- 定期的プローブ: ロード バランサーは、定期的な間隔でバックエンド サーバーにリクエストを送信します。

- 応答評価: 応答を評価して、サーバーが正常かどうかを判断します。

- カスタマイズ可能なチェック: ヘルス チェックは、ping のように単純なものも、特定のページをリクエストしてコンテンツを評価するような複雑なものも可能です。

失敗したヘルスチェックの処理

サーバーがヘルスチェックに失敗した場合:

- ロード バランサは、アクティブ サーバーのプールからそのサーバーを削除します。

- トラフィックは正常なサーバーにリダイレクトされます。

- ロード バランサは障害が発生したサーバーのチェックを継続し、ヘルス チェックに再度合格すると、そのサーバーをプールに再導入します。

セッションの永続性

セッション永続性はスティッキー セッションとも呼ばれ、クライアントのリクエストが常に同じバックエンド サーバーにルーティングされるようにします。

セッション永続性を使用する場合

- ステートフル アプリケーション: アプリケーションがサーバー上で状態を維持する場合。

- ショッピング カート: ユーザーのセッション中にカートの一貫性が保たれるようにするため。

- プログレッシブ ワークフロー: 状態を維持する必要がある複数ステップのプロセス用。

セッションの永続化を避けるべき場合

- ステートレス アプリケーション: アプリケーションがサーバー側の状態に依存しない場合。

- 非常に動的なコンテンツ: どのサーバーでもあらゆるリクエストを同様に適切に処理できるアプリケーション用。

- スケーリングが優先される場合: スティッキーなセッションにより、スケーリングとサーバーのメンテナンスが複雑になる可能性があります。

SSL/TLS終端

SSL/TLS 終了は、暗号化されたトラフィックをバックエンド サーバーに渡す前に、ロード バランサで復号化するプロセスです。

SSL/TLS 終端の重要性

- サーバー負荷の軽減: 暗号化/復号化という計算コストのかかるタスクをアプリケーション サーバーからオフロードします。

- 集中型 SSL 管理: 証明書の管理をロード バランサーで一元化することで簡素化します。

- セキュリティの強化: ロード バランサが HTTPS トラフィックを検査してフィルタリングできるようにします。

SSL/TLS 終端の構成

- ロード バランサーに SSL 証明書をインストールします。

- HTTPS ポート (通常は 443) をリッスンするようにロード バランサーを構成します。

- バックエンド通信を設定します。セキュリティ要件に応じて、暗号化または非暗号化のいずれかを選択できます。

一般的な問題とトラブルシューティング

- 不均一な負荷分散: 一部のサーバーが他のサーバーよりも不釣り合いに多くのトラフィックを受信しています。

- セッション永続性の問題: ユーザーがセッション データを失うか、間違ったサーバーにルーティングされます。

- SSL 証明書の問題: 証明書の有効期限が切れているか、設定が間違っているため、接続の問題が発生します。

- ヘルス チェックの失敗: ヘルス チェックが過度に積極的であるか、設定が不適切で、正常なサーバーがダウンしているとマークされています。

- パフォーマンスのボトルネック: トラフィックが多い場合、ロード バランサ自体がボトルネックになります。

トラブルシューティングのテクニック

- ログ分析: ロード バランサーとサーバーのログを調べて、パターンや異常を特定します。

- 監視ツール: 包括的な監視ソリューションを使用して、パフォーマンス指標を追跡し、問題を特定します。

- テスト: 負荷テストを定期的に実行して、セットアップが予想されるトラフィック量を処理できることを確認します。

- 構成のレビュー: ロード バランサーの設定を定期的に確認して最適化します。

- ネットワーク分析: tcpdump や Wireshark などのツールを使用して、ネットワーク トラフィックの問題を分析します。

結論

ロード バランサーは、最新のシステム アーキテクチャに不可欠なツールであり、スケーラブルで信頼性が高く、パフォーマンスの高いアプリケーションの基盤を提供します。トラフィックを効率的に分散し、スケーリングを促進し、フォールト トレランスを向上させることで、ロード バランサーは最適なユーザー エクスペリエンスを確保する上で重要な役割を果たします。

インフラストラクチャにロード バランサーを実装して管理する場合、成功の鍵はアプリケーション固有のニーズを理解し、適切なタイプのロード バランサーを選択し、セットアップを継続的に監視して最適化することにあることを忘れないでください。このガイドから得た知識があれば、システム アーキテクチャでロード バランサを効果的に活用するための準備が整います。

-

Python環境変数のアクセスおよび管理方法Python の環境変数へのアクセスPythonの環境変数にアクセスするには、 os.environ オブジェクトを利用します。デフォルトでは、マッピング内の変数にアクセスすると、インタープリターにPython辞書の値を検索するようにプロンプトが表示されます。 print(os.e...プログラミング 2025-05-25に投稿されました

Python環境変数のアクセスおよび管理方法Python の環境変数へのアクセスPythonの環境変数にアクセスするには、 os.environ オブジェクトを利用します。デフォルトでは、マッピング内の変数にアクセスすると、インタープリターにPython辞書の値を検索するようにプロンプトが表示されます。 print(os.e...プログラミング 2025-05-25に投稿されました -

Appengineでは、エラー「ファイルタイプを推測できない、アプリケーション/Octet-Streamを使用できません...」を解くにはどうすればよいですか?appengine static file mime mime type override appengineでは、正しいマイムタイプを時々オーバーライドすることができます。 Application/Octet-Stream ... " 問題解決 ]を修正し、...プログラミング 2025-05-25に投稿されました

Appengineでは、エラー「ファイルタイプを推測できない、アプリケーション/Octet-Streamを使用できません...」を解くにはどうすればよいですか?appengine static file mime mime type override appengineでは、正しいマイムタイプを時々オーバーライドすることができます。 Application/Octet-Stream ... " 問題解決 ]を修正し、...プログラミング 2025-05-25に投稿されました -

一定の列を追加するためのSpark DataFrameのヒントスパークデータフレームに一定の列を作成する すべての行に適用される任意の値で一定の列をスパークデータフレームに追加することができます。この目的を目的としたwithcolumnメソッドは、2番目の引数として直接的な値を提供しようとするときにエラーを引き起こす可能性があります。点灯 df.wi...プログラミング 2025-05-25に投稿されました

一定の列を追加するためのSpark DataFrameのヒントスパークデータフレームに一定の列を作成する すべての行に適用される任意の値で一定の列をスパークデータフレームに追加することができます。この目的を目的としたwithcolumnメソッドは、2番目の引数として直接的な値を提供しようとするときにエラーを引き起こす可能性があります。点灯 df.wi...プログラミング 2025-05-25に投稿されました -

Regexを使用してPHPで括弧内で効率的にテキストを抽出する方法php:括弧内の括弧内のテキストの抽出 括弧内に囲まれたテキストの抽出を扱うとき、最も効率的なソリューションを見つけることが不可欠です。 1つのアプローチは、以下に示すように、PHPの文字列操作関数を利用することです。 $ fullstring); $ sportstring = s...プログラミング 2025-05-25に投稿されました

Regexを使用してPHPで括弧内で効率的にテキストを抽出する方法php:括弧内の括弧内のテキストの抽出 括弧内に囲まれたテキストの抽出を扱うとき、最も効率的なソリューションを見つけることが不可欠です。 1つのアプローチは、以下に示すように、PHPの文字列操作関数を利用することです。 $ fullstring); $ sportstring = s...プログラミング 2025-05-25に投稿されました -

MySQLデータベースメソッドは、同じインスタンスをダンプする必要はありません同じインスタンスでmysqlデータベースをコピーする 同じmysqlインスタンスでデータベースをコピーすることはできません。以下の方法は、従来のダンプアンドインポートプロセスのより簡単な代替手段を提供します。 | mysql new_db_name このコマンドは、new_db_nam...プログラミング 2025-05-25に投稿されました

MySQLデータベースメソッドは、同じインスタンスをダンプする必要はありません同じインスタンスでmysqlデータベースをコピーする 同じmysqlインスタンスでデータベースをコピーすることはできません。以下の方法は、従来のダンプアンドインポートプロセスのより簡単な代替手段を提供します。 | mysql new_db_name このコマンドは、new_db_nam...プログラミング 2025-05-25に投稿されました -

なぜPHPのDateTime :: Modify( '+1 Month')が予期しない結果を生み出すのですか?PHP DateTimeで月数の変更:PHPのDateTimeクラスを操作する場合、数か月を追加または減算する場合、意図した動作を発見します。ドキュメントが警告しているように、これらの操作は見た目ほど直感的ではないため、これらの操作に「注意してください」。 $ date-> modify(...プログラミング 2025-05-25に投稿されました

なぜPHPのDateTime :: Modify( '+1 Month')が予期しない結果を生み出すのですか?PHP DateTimeで月数の変更:PHPのDateTimeクラスを操作する場合、数か月を追加または減算する場合、意図した動作を発見します。ドキュメントが警告しているように、これらの操作は見た目ほど直感的ではないため、これらの操作に「注意してください」。 $ date-> modify(...プログラミング 2025-05-25に投稿されました -

CSSは、属性値に基づいてHTML要素を見つけることができますか?をCSS の属性値でHTML要素をターゲットとするCSSのターゲティング、以下の例に示すように、特定の属性に基づいてターゲット要素をターゲットにすることが可能です: [型]入力[型]入力[タイプ] { フォントファミリー:コンソラ。 } input[type=text] { ...プログラミング 2025-05-25に投稿されました

CSSは、属性値に基づいてHTML要素を見つけることができますか?をCSS の属性値でHTML要素をターゲットとするCSSのターゲティング、以下の例に示すように、特定の属性に基づいてターゲット要素をターゲットにすることが可能です: [型]入力[型]入力[タイプ] { フォントファミリー:コンソラ。 } input[type=text] { ...プログラミング 2025-05-25に投稿されました -

Pandas DataFramesで列を効率的に選択するにはどうすればよいですか?Pandas DataFrames の列の選択データ操作タスクを扱うと、特定の列の選択が必要になります。パンダでは、列を選択するためのさまざまなオプションがあります。数値インデックス 列インデックスがわかっている場合、ILOC関数を使用してそれらを選択します。 Pythonインデック...プログラミング 2025-05-25に投稿されました

Pandas DataFramesで列を効率的に選択するにはどうすればよいですか?Pandas DataFrames の列の選択データ操作タスクを扱うと、特定の列の選択が必要になります。パンダでは、列を選択するためのさまざまなオプションがあります。数値インデックス 列インデックスがわかっている場合、ILOC関数を使用してそれらを選択します。 Pythonインデック...プログラミング 2025-05-25に投稿されました -

Javaの「DD/MM/YYYY HH:MM:SS.SS」形式で現在の日付と時刻を正しく表示するにはどうすればよいですか?「dd/mm/yyyy hh:mm:ss.ss」形式で現在の日付と時刻を表示する方法。異なるフォーマットパターンを持つさまざまなSimpleDateFormatインスタンスの使用にあります。 java.text.simpledateformat; java.util.calendarをインポ...プログラミング 2025-05-25に投稿されました

Javaの「DD/MM/YYYY HH:MM:SS.SS」形式で現在の日付と時刻を正しく表示するにはどうすればよいですか?「dd/mm/yyyy hh:mm:ss.ss」形式で現在の日付と時刻を表示する方法。異なるフォーマットパターンを持つさまざまなSimpleDateFormatインスタンスの使用にあります。 java.text.simpledateformat; java.util.calendarをインポ...プログラミング 2025-05-25に投稿されました -

フォームリフレッシュ後に重複した提出を防ぐ方法は?を更新することで重複した提出を防ぐ Web開発で、フォームの提出後にページが更新された場合に重複した提出の問題に遭遇することが一般的です。これに対処するには、次のアプローチを検討してください。 if(isset($ _ post ['name'])){ ...プログラミング 2025-05-25に投稿されました

フォームリフレッシュ後に重複した提出を防ぐ方法は?を更新することで重複した提出を防ぐ Web開発で、フォームの提出後にページが更新された場合に重複した提出の問題に遭遇することが一般的です。これに対処するには、次のアプローチを検討してください。 if(isset($ _ post ['name'])){ ...プログラミング 2025-05-25に投稿されました -

PHP Future:適応と革新PHPの将来は、新しいテクノロジーの傾向に適応し、革新的な機能を導入することで達成されます。1)クラウドコンピューティング、コンテナ化、マイクロサービスアーキテクチャに適応し、DockerとKubernetesをサポートします。 2)パフォーマンスとデータ処理の効率を改善するために、JITコンパイ...プログラミング 2025-05-25に投稿されました

PHP Future:適応と革新PHPの将来は、新しいテクノロジーの傾向に適応し、革新的な機能を導入することで達成されます。1)クラウドコンピューティング、コンテナ化、マイクロサービスアーキテクチャに適応し、DockerとKubernetesをサポートします。 2)パフォーマンスとデータ処理の効率を改善するために、JITコンパイ...プログラミング 2025-05-25に投稿されました -

3つのMySQLテーブルのデータを新しいテーブルに組み合わせる方法は?mysql:3つのテーブルのデータと列から新しいテーブルを作成する 質問: 人々、詳細、および分類表の表? P。*、d.contentを年齢として選択します psとしての人々から D.Person_id = p.idのDとして詳細を結合します t.id = d.detail_idでt...プログラミング 2025-05-25に投稿されました

3つのMySQLテーブルのデータを新しいテーブルに組み合わせる方法は?mysql:3つのテーブルのデータと列から新しいテーブルを作成する 質問: 人々、詳細、および分類表の表? P。*、d.contentを年齢として選択します psとしての人々から D.Person_id = p.idのDとして詳細を結合します t.id = d.detail_idでt...プログラミング 2025-05-25に投稿されました -

CSS「コンテンツ」プロパティを使用してFirefoxが画像を表示しないのはなぜですか?firefox のコンテンツURLを使用して画像を表示します。これは、提供されたCSSクラスで見ることができます: .googlePic { content: url('../../img/googlePlusIcon.PNG'); margin-top: -6.5%;...プログラミング 2025-05-25に投稿されました

CSS「コンテンツ」プロパティを使用してFirefoxが画像を表示しないのはなぜですか?firefox のコンテンツURLを使用して画像を表示します。これは、提供されたCSSクラスで見ることができます: .googlePic { content: url('../../img/googlePlusIcon.PNG'); margin-top: -6.5%;...プログラミング 2025-05-25に投稿されました -

Java文字列に複数のサブストリングを効率的に交換するにはどうすればよいですか?java で複数のサブストリングを弦の複数のサブストリングを置き換えると、文字列内の複数のサブストリングを置き換える必要性に直面すると、弦楽列の方法を繰り返し担当するブルートのアプローチに頼ることに魅力的です。ただし、これは大きな文字列や多数の文字列を使用する場合は非効率的です。正規表...プログラミング 2025-05-25に投稿されました

Java文字列に複数のサブストリングを効率的に交換するにはどうすればよいですか?java で複数のサブストリングを弦の複数のサブストリングを置き換えると、文字列内の複数のサブストリングを置き換える必要性に直面すると、弦楽列の方法を繰り返し担当するブルートのアプローチに頼ることに魅力的です。ただし、これは大きな文字列や多数の文字列を使用する場合は非効率的です。正規表...プログラミング 2025-05-25に投稿されました -

右からCSSの背景画像を見つける方法は?右からの背景画像をCSS をWeb開発の領域で配置すると、要素内に背景画像を正確に配置することが望ましいことがよくあります。要素の左側に関連する背景画像を配置するのは簡単ですが、右から特定の数のピクセルをオフセットするにはどうすればよいですか? /を右から10pxを配置するための動作...プログラミング 2025-05-25に投稿されました

右からCSSの背景画像を見つける方法は?右からの背景画像をCSS をWeb開発の領域で配置すると、要素内に背景画像を正確に配置することが望ましいことがよくあります。要素の左側に関連する背景画像を配置するのは簡単ですが、右から特定の数のピクセルをオフセットするにはどうすればよいですか? /を右から10pxを配置するための動作...プログラミング 2025-05-25に投稿されました

中国語を勉強する

- 1 「歩く」は中国語で何と言いますか? 走路 中国語の発音、走路 中国語学習

- 2 「飛行機に乗る」は中国語で何と言いますか? 坐飞机 中国語の発音、坐飞机 中国語学習

- 3 「電車に乗る」は中国語で何と言いますか? 坐火车 中国語の発音、坐火车 中国語学習

- 4 「バスに乗る」は中国語で何と言いますか? 坐车 中国語の発音、坐车 中国語学習

- 5 中国語でドライブは何と言うでしょう? 开车 中国語の発音、开车 中国語学習

- 6 水泳は中国語で何と言うでしょう? 游泳 中国語の発音、游泳 中国語学習

- 7 中国語で自転車に乗るってなんて言うの? 骑自行车 中国語の発音、骑自行车 中国語学習

- 8 中国語で挨拶はなんて言うの? 你好中国語の発音、你好中国語学習

- 9 中国語でありがとうってなんて言うの? 谢谢中国語の発音、谢谢中国語学習

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning