Más allá de JavaScript: por qué + no es igual en programación

Con frecuencia se ridiculiza JavaScript cuando los desarrolladores encuentran por primera vez este resultado aparentemente desconcertante:

0.1 0.2 == 0.30000000000000004

Los memes sobre el manejo de números por parte de JavaScript están muy extendidos, lo que a menudo lleva a muchos a creer que este comportamiento es exclusivo del lenguaje.

Sin embargo, esta peculiaridad no se limita solo a JavaScript. Es una consecuencia de cómo la mayoría de los lenguajes de programación manejan la aritmética de punto flotante.

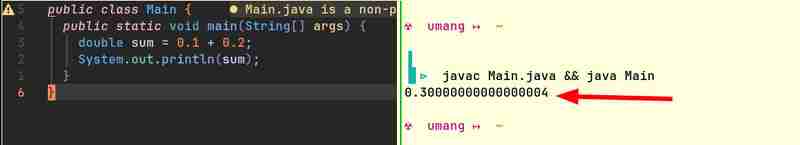

Por ejemplo, aquí hay fragmentos de código de Java y Go que producen resultados similares:

Las computadoras de forma nativa solo pueden almacenar números enteros. No entienden fracciones. (¿Cómo lo harán? La única forma en que las computadoras pueden hacer aritmética es encendiendo o apagando algunas luces. La luz puede estar encendida o apagada. ¡No puede estar "medio" encendida!) Necesitan alguna forma de representar números de coma flotante . Dado que esta representación no es perfectamente precisa, la mayoría de las veces, 0,1 0,2 no es igual a 0,3.

Todas las fracciones cuyos denominadores están formados por factores primos de la base del sistema numérico se pueden expresar claramente, mientras que cualquier otra fracción tendría decimales periódicos. Por ejemplo, en el sistema numérico con base 10, fracciones como 1/2, 1/4, 1/5, 1/10 se representan claramente porque los denominadores en cada caso se componen de 2 o 5, los factores primos de 10. Sin embargo, fracciones como 1/3, 1/6, 1/7 tienen decimales recurrentes.

De manera similar, en el sistema binario, fracciones como 1/2, 1/4, 1/8 se expresan claramente, mientras que todas las demás fracciones tienen decimales recurrentes. Cuando realiza aritmética con estos decimales recurrentes, termina con restos que se transfieren cuando convierte la representación binaria de números de la computadora a una representación de base 10 legible por humanos. Esto es lo que conduce a resultados aproximadamente correctos.

Ahora que hemos establecido que este problema no es exclusivo de JavaScript, exploremos cómo se representan y procesan los números de punto flotante para comprender por qué ocurre este comportamiento.

Para comprender cómo se representan y procesan los números de punto flotante, primero tendríamos que comprender el estándar de punto flotante IEEE 754.

El estándar IEEE 754 es una especificación ampliamente utilizada para representar y realizar aritmética en números de punto flotante en sistemas informáticos. Fue creado para garantizar la coherencia al utilizar la aritmética de punto flotante en varias plataformas informáticas. La mayoría de los lenguajes de programación e implementaciones de hardware (CPU, GPU, etc.) se adhieren a este estándar.

Así es como se indica un número en formato IEEE 754:

Aquí s es el bit de signo (0 para positivo, 1 para negativo), M es la mantisa (contiene los dígitos del número) y E es el exponente que determina la escala del número.

No podrás encontrar ningún valor entero para M y E que pueda representar exactamente números como 0,1, 0,2 o 0,3 en este formato. Solo podemos elegir valores para M y E que den el resultado más cercano.

Aquí hay una herramienta que puede utilizar para determinar las notaciones IEEE 754 de números decimales: https://www.h-schmidt.net/FloatConverter/IEEE754.html

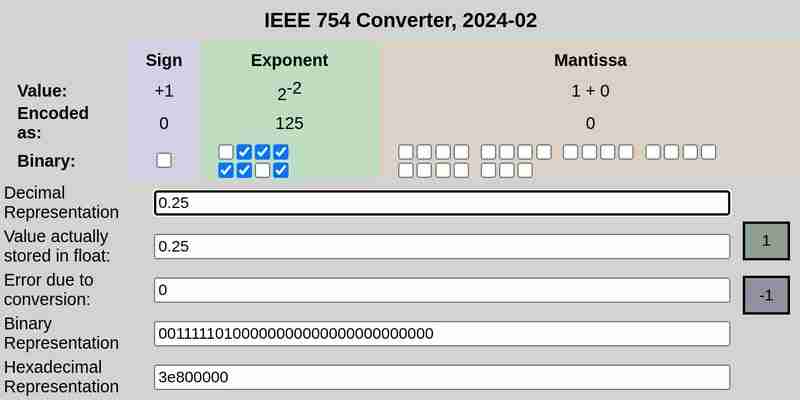

Notación IEEE 754 de 0,25:

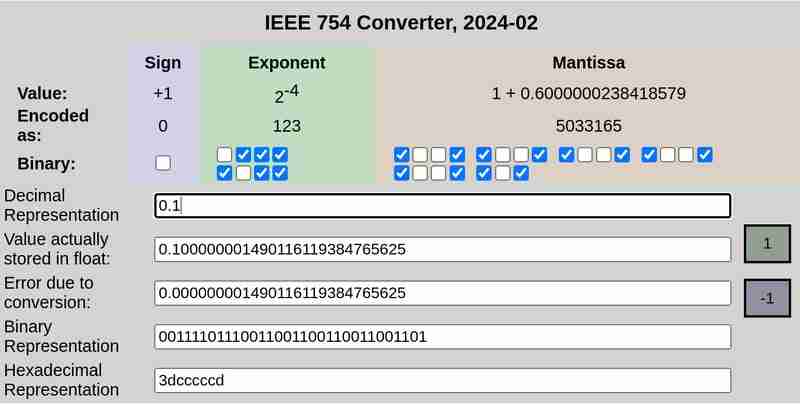

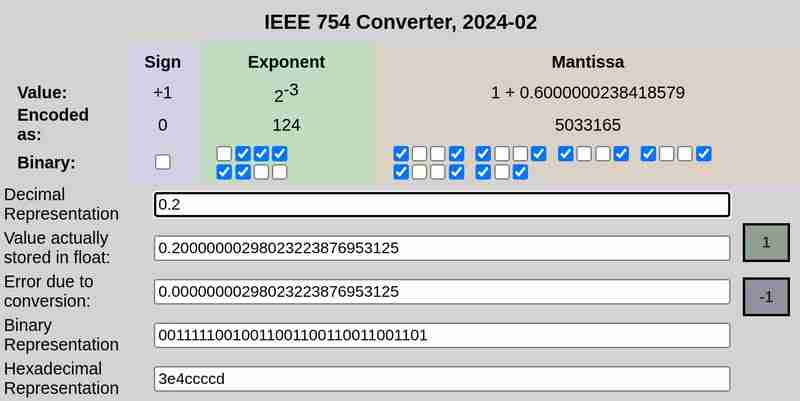

Notación IEEE 754 de 0,1 y 0,2 respectivamente:

Tenga en cuenta que el error debido a la conversión en el caso de 0.25 fue 0, mientras que 0.1 y 0.2 tuvieron errores distintos de cero.

IEEE 754 define los siguientes formatos para representar números de punto flotante:

Precisión simple (32 bits): 1 bit para signo, 8 bits para exponente, 23 bits para mantisa

Doble precisión (64 bits): 1 bit para signo, 11 bits para exponente, 52 bits para mantisa

En aras de la simplicidad, consideremos el formato de precisión simple que utiliza 32 bits.

La representación de 32 bits de 0.1 es:

0 01111011 10011001100110011001101

Aquí el primer bit representa el signo (0 que significa positivo en este caso), los siguientes 8 bits (01111011) representan el exponente y los últimos 23 bits (10011001100110011001101) representan la mantisa.

Esta no es una representación exacta. Representa ≈ 0.100000001490116119384765625

De manera similar, la representación de 32 bits de 0.2 es:

0 01111100 10011001100110011001101

Esta tampoco es una representación exacta. Representa ≈ 0.20000000298023223876953125

Cuando se agrega, esto da como resultado:

0 01111101 11001101010011001100110

que es ≈ 0.30000001192092896 en representación decimal.

En conclusión, el resultado aparentemente desconcertante de que 0,1 0,2 no arroja 0,3 no es una anomalía específica de JavaScript, sino una consecuencia de las limitaciones de la aritmética de punto flotante en todos los lenguajes de programación. Las raíces de este comportamiento se encuentran en la representación binaria de números, que inherentemente conduce a errores de precisión al manejar ciertas fracciones.

-

Python Metaclass Principio de trabajo y creación y personalización de clases¿Qué son los metaclasses en Python? MetAclasses son responsables de crear objetos de clase en Python. Así como las clases crean instancias, las ...Programación Publicado el 2025-05-05

Python Metaclass Principio de trabajo y creación y personalización de clases¿Qué son los metaclasses en Python? MetAclasses son responsables de crear objetos de clase en Python. Así como las clases crean instancias, las ...Programación Publicado el 2025-05-05 -

¿Cómo enviar una solicitud de publicación en bruto con Curl en PHP?Cómo enviar una solicitud de publicación sin procesar usando curl en php en php, Curl es una biblioteca popular para enviar solicitudes HTTP. ...Programación Publicado el 2025-05-05

¿Cómo enviar una solicitud de publicación en bruto con Curl en PHP?Cómo enviar una solicitud de publicación sin procesar usando curl en php en php, Curl es una biblioteca popular para enviar solicitudes HTTP. ...Programación Publicado el 2025-05-05 -

¿Cómo puedo unir tablas de bases de datos con diferentes números de columnas?tablas combinadas con diferentes columnas ]] puede encontrar desafíos al intentar fusionar las tablas de la base de datos con diferentes column...Programación Publicado el 2025-05-05

¿Cómo puedo unir tablas de bases de datos con diferentes números de columnas?tablas combinadas con diferentes columnas ]] puede encontrar desafíos al intentar fusionar las tablas de la base de datos con diferentes column...Programación Publicado el 2025-05-05 -

¿Cómo detectar eficientemente las matrices vacías en PHP?Comprobando el vacío de la matriz en php una matriz vacía se puede determinar en PHP a través de varios enfoques. Si la necesidad es verificar...Programación Publicado el 2025-05-05

¿Cómo detectar eficientemente las matrices vacías en PHP?Comprobando el vacío de la matriz en php una matriz vacía se puede determinar en PHP a través de varios enfoques. Si la necesidad es verificar...Programación Publicado el 2025-05-05 -

¿Cómo usar correctamente las consultas como los parámetros PDO?usando consultas similares en pdo al intentar implementar una consulta similar en PDO, puede encontrar problemas como el que se describe en la...Programación Publicado el 2025-05-05

¿Cómo usar correctamente las consultas como los parámetros PDO?usando consultas similares en pdo al intentar implementar una consulta similar en PDO, puede encontrar problemas como el que se describe en la...Programación Publicado el 2025-05-05 -

¿Cómo se extraen un elemento aleatorio de una matriz en PHP?Selección aleatoria de una matriz en php, la obtención de un elemento aleatorio de una matriz se puede lograr con facilidad. Considere la siguie...Programación Publicado el 2025-05-05

¿Cómo se extraen un elemento aleatorio de una matriz en PHP?Selección aleatoria de una matriz en php, la obtención de un elemento aleatorio de una matriz se puede lograr con facilidad. Considere la siguie...Programación Publicado el 2025-05-05 -

¿Cómo capturar y transmitir stdout en tiempo real para la ejecución del comando de chatbot?capturando stdout en tiempo real desde la ejecución de comandos en el reino de desarrollar chatbots capaces de ejecutar comandos, un requisito...Programación Publicado el 2025-05-05

¿Cómo capturar y transmitir stdout en tiempo real para la ejecución del comando de chatbot?capturando stdout en tiempo real desde la ejecución de comandos en el reino de desarrollar chatbots capaces de ejecutar comandos, un requisito...Programación Publicado el 2025-05-05 -

¿Cómo puedo crear eficientemente diccionarios utilizando la comprensión de Python?Python Dictionary Comprension en Python, las comprensiones del diccionario ofrecen una forma concisa de generar nuevos diccionarios. Si bien son...Programación Publicado el 2025-05-05

¿Cómo puedo crear eficientemente diccionarios utilizando la comprensión de Python?Python Dictionary Comprension en Python, las comprensiones del diccionario ofrecen una forma concisa de generar nuevos diccionarios. Si bien son...Programación Publicado el 2025-05-05 -

¿Cómo implementar una función hash genérica para tuplas en colecciones desordenadas?Función hash genérica para tuplas en colecciones no ordenadas los contenedores std :: unordened_map y std :: unordened_set proporcionan una mi...Programación Publicado el 2025-05-05

¿Cómo implementar una función hash genérica para tuplas en colecciones desordenadas?Función hash genérica para tuplas en colecciones no ordenadas los contenedores std :: unordened_map y std :: unordened_set proporcionan una mi...Programación Publicado el 2025-05-05 -

Razones para que CodeIgniter se conecte a la base de datos MySQL después de cambiar a MySQLINo se puede conectar a la base de datos mySQL: Mensaje de error de solución de problemas al intentar cambiar desde el controlador mySQL al con...Programación Publicado el 2025-05-05

Razones para que CodeIgniter se conecte a la base de datos MySQL después de cambiar a MySQLINo se puede conectar a la base de datos mySQL: Mensaje de error de solución de problemas al intentar cambiar desde el controlador mySQL al con...Programación Publicado el 2025-05-05 -

Eval () vs. AST.LITERAL_EVAL (): ¿Qué función de Python es más segura para la entrada del usuario?pesando eval () y Ast.literal_eval () en Python Security Al manejar la entrada del usuario, es imperativo priorizar la seguridad. eval (), una...Programación Publicado el 2025-05-05

Eval () vs. AST.LITERAL_EVAL (): ¿Qué función de Python es más segura para la entrada del usuario?pesando eval () y Ast.literal_eval () en Python Security Al manejar la entrada del usuario, es imperativo priorizar la seguridad. eval (), una...Programación Publicado el 2025-05-05 -

¿Cómo lidiar con la memoria en rodajas en la recolección de basura del idioma GO?colección de basura en cortes de Go: un análisis detallado en Go, una porción es una matriz dinámica que hace referencia a una matriz subyacen...Programación Publicado el 2025-05-05

¿Cómo lidiar con la memoria en rodajas en la recolección de basura del idioma GO?colección de basura en cortes de Go: un análisis detallado en Go, una porción es una matriz dinámica que hace referencia a una matriz subyacen...Programación Publicado el 2025-05-05 -

¿Cómo analizar los números en notación exponencial usando decimal.parse ()?analizando un número de la notación exponencial cuando intenta analizar una cadena expresada en notación exponencial usando decimal.parse (&qu...Programación Publicado el 2025-05-05

¿Cómo analizar los números en notación exponencial usando decimal.parse ()?analizando un número de la notación exponencial cuando intenta analizar una cadena expresada en notación exponencial usando decimal.parse (&qu...Programación Publicado el 2025-05-05 -

Cómo definir concisamente una constante de potencia de 10 en el idioma GOescribiendo poderes de 10 como constantes compactas en Go en el lenguaje de programación GO, definir poderes de 10 como constantes es una tare...Programación Publicado el 2025-05-05

Cómo definir concisamente una constante de potencia de 10 en el idioma GOescribiendo poderes de 10 como constantes compactas en Go en el lenguaje de programación GO, definir poderes de 10 como constantes es una tare...Programación Publicado el 2025-05-05 -

¿Cómo puede definir variables en plantillas de cuchilla de laravel elegantemente?Definición de variables en plantillas de Blade Laravel con elegancia Comprender cómo asignar variables en plantillas de cuchillas es crucial p...Programación Publicado el 2025-05-05

¿Cómo puede definir variables en plantillas de cuchilla de laravel elegantemente?Definición de variables en plantillas de Blade Laravel con elegancia Comprender cómo asignar variables en plantillas de cuchillas es crucial p...Programación Publicado el 2025-05-05

Estudiar chino

- 1 ¿Cómo se dice "caminar" en chino? 走路 pronunciación china, 走路 aprendizaje chino

- 2 ¿Cómo se dice "tomar un avión" en chino? 坐飞机 pronunciación china, 坐飞机 aprendizaje chino

- 3 ¿Cómo se dice "tomar un tren" en chino? 坐火车 pronunciación china, 坐火车 aprendizaje chino

- 4 ¿Cómo se dice "tomar un autobús" en chino? 坐车 pronunciación china, 坐车 aprendizaje chino

- 5 ¿Cómo se dice conducir en chino? 开车 pronunciación china, 开车 aprendizaje chino

- 6 ¿Cómo se dice nadar en chino? 游泳 pronunciación china, 游泳 aprendizaje chino

- 7 ¿Cómo se dice andar en bicicleta en chino? 骑自行车 pronunciación china, 骑自行车 aprendizaje chino

- 8 ¿Cómo se dice hola en chino? 你好Pronunciación china, 你好Aprendizaje chino

- 9 ¿Cómo se dice gracias en chino? 谢谢Pronunciación china, 谢谢Aprendizaje chino

- 10 How to say goodbye in Chinese? 再见Chinese pronunciation, 再见Chinese learning